Le thème de l’intelligence artificielle (IA), outre les nécessaires tentatives de définitions et de clarifications, est souvent très polarisant. Certains voient cette technologie comme regorgeant de possibilités pour un monde et un avenir meilleurs, d’autres y voient la certitude d’une humanité qui finira en lambeaux, faute de contrôle possible face à une chimère aussi puissante. Parmi les arguments défendant le potentiel de l’IA tout en reconnaissant éventuellement ses biais et possibles discriminations, nous retrouvons cette idée largement partagée que l’IA ne serait finalement qu’un outil. Cela sous-entend que l’incidence, la portée et les effets de cette technologie dépendront de ce que nous en faisons. Mais est-ce si simple ? Pas tout à fait. En tant que chercheures travaillant sur les impacts sociétaux de l’intelligence artificielle et particulièrement sur la justice sociale, nous souhaitons apporter notre éclairage sur cette question.

DES ROBOTS SOCIAUX ?

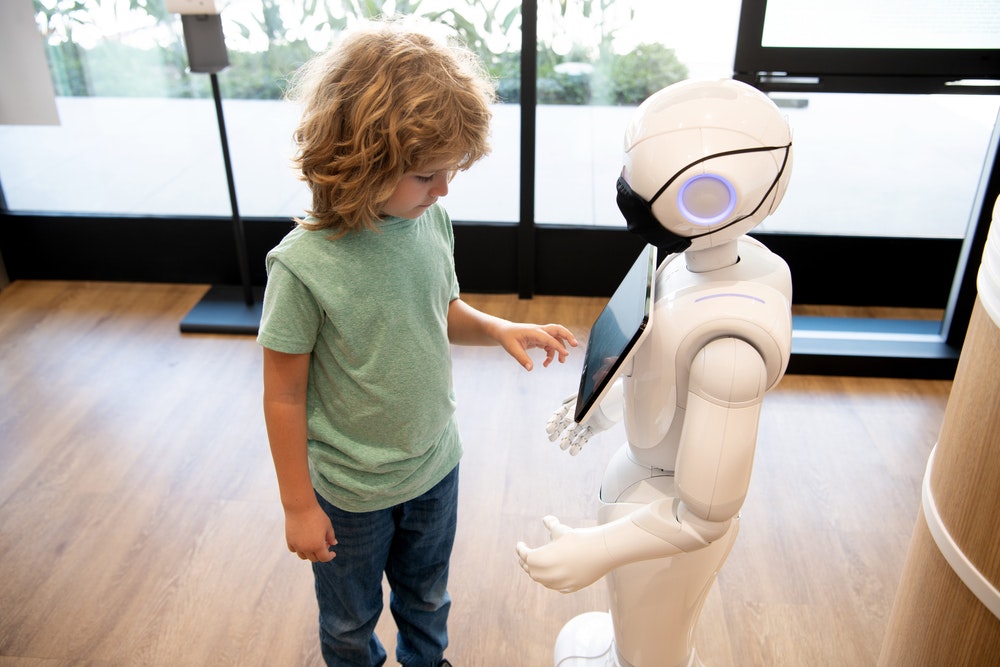

Premièrement, l’IA est bien plus qu’un outil, car son développement reflète avant tout une certaine vision du monde et des interactions humaines et sociales. Par exemple, SoftBank Robotics, qui produit les robots humanoïdes NAO et Pepper, construits grâce à des systèmes d’IA développés notamment pour la détection faciale avec port du masque, investit massivement la sphère de la santé, particulièrement pour assister les personnes âgées. Une version plus simple du robot NAO, appelée Zora, garantie par ses développeurs « 100 % intelligence humaine », peut stimuler, distraire, informer, entraîner et faire danser les personnes âgées. En cela, c’est un outil. Cependant, la décision d’introduire ce robot dans les milieux de vie met potentiellement en lumière l’échec d’une prise en compte humaine des personnes âgées. À l’heure des compressions budgétaires dans les hôpitaux et dans les résidences pour aînés soumises à des logiques de rentabilité, il est difficile de ne pas voir ces robots comme une réponse technologique face à l’allègement des ressources humaines. C’est en cela un choix de société. Qualifier ces artefacts de « robots sociaux » ou souhaiter qu’ils aient une « dimension morale » ne change rien à la problématique. La dimension morale des robots était évoquée par l’écrivain de fiction Isaac Asimov, déjà en 1942, dans ses 3 lois de la robotique. Selon sa loi numéro 1, Un robot ne peut porter atteinte à un être humain ni, restant passif, laisser cet être humain exposé au danger. Les bonnes intentions et les énoncés de principe ne suffisent pas, car aujourd’hui, l’intelligence artificielle révèle et renforce une représentation du monde au sein de laquelle la solidarité humaine et le tissu social semblent s’éroder.

UNE QUESTION DE JUSTICE SOCIALE

Deuxièmement, si certains affirment que ce n’est qu’un outil, cela suppose que chaque personne peut jouir de son usage et que ses droits fondamentaux ne seront pas impactés. Or, c’est ignorer les asymétries de pouvoir qui existent au sein de l’écosystème de l’IA ainsi que les incidences documentées sur les droits humains. En effet, qui est aux commandes ? À l’heure actuelle, les citoyens ne sont pas associés à la création des systèmes d’IA, ce qui est à l’origine de biais algorithmiques fréquemment relevés. Les citoyens ne participent pas non plus à la définition des visions du monde que dessinent les IA développées en ce moment. Le seul contre-pouvoir repose sur les tentatives actuelles de réguler et de minimiser les biais et les impacts négatifs de l’IA sur la société. En effet, les États, des institutions supranationales comme l’Union européenne, le Conseil de l’Europe ou encore des organisations internationales telles que l’Unesco par exemple, tentent de mettre en place des mécanismes pour atténuer et encadrer les risques liés à l’IA. La régulation est une bonne chose, mais il faudrait également, en amont du déploiement de cette technologie, être capable de définir les besoins sociaux, éducatifs, judiciaires, médicaux, environnementaux auxquels devrait répondre l’IA. Autrement dit, avant toute conception et diffusion des technologies d’IA, une concertation ouverte et publique sur la nature des besoins qu’elle vient combler et sur la manière de le faire pourrait éviter d’agir après coup, comme c’est le cas quand des organisations se mobilisent pour mitiger des risques ou atténuer des biais déjà existants.

LA TECHNOLOGIE N’EST PAS LE REMEDE A TOUS LES MAUX

Et puis il serait temps d’admettre que l’IA ne peut pas tout résoudre, et ainsi d’en finir avec le technosolutionnisme. Le technosolutionnisme est cette idéologie qui répand l’idée qu’il existe une technologie pour chaque problème rencontré : un robot pour améliorer la prise en charge des aînés comme nous l’avons vu, ou encore des applications mobiles pour arrêter l’insécurité alimentaire en Afrique, une IA pour lutter contre les changements climatiques ou des algorithmes pour faire diminuer le chômage, pour ne citer que quelques exemples. Or, il est possible que la meilleure réponse à un problème social, environnemental ou de santé publique ne soit finalement pas toujours technologique, mais plutôt humaine, économique ou politique. Par ailleurs, dans un contexte d’épuisement des ressources et de crise écologique majeure, une attention particulière devrait être portée à la sobriété numérique.

En effet, les technologies numériques sont extrêmement coûteuses en énergie, en matériaux rares et génèrent un grand nombre de déchets, liés notamment à l’obsolescence programmée, mais aussi à l’encouragement de la surconsommation. Par exemple, la sécheresse qu’a connue Taïwan en 2021 a révélé les quantités d’eau nécessaires à la fabrication des puces électroniques. Cette année-là, le gouvernement a fait le choix d’interdire l’arrosage des terres agricoles pour que l’industrie des puces électroniques puisse continuer à fabriquer et vendre ses produits indispensables à de nombreuses technologies numériques. C’est pourquoi il est essentiel de pouvoir collectivement définir quand les systèmes d’IA sont requis, par qui, pour qui et en fonction de quels besoins et objectifs nous devons les déployer. L’intelligence artificielle est intimement liée à des enjeux de pouvoir et nécessite une « démocratisation radicale », pour reprendre les mots du chercheur Pieter Verdegem. Dans son ouvrage AI for Everyone ? Critical Perspectives (2021), il rappelle que l’IA doit être accessible à chacun, tous nous représenter et bénéficier à tout le monde sans exception.

L’IA DEVRAIT SERVIR LE BIEN COMMUN

Selon nous, pour être considérée comme un outil, cette technologie devrait être gouvernée comme un commun. Comme l’a théorisée Elinor Ostrom, politologue et économiste américaine, un commun est une ressource partagée dans l’intérêt général et dont la gouvernance doit permettre l’inclusion et la participation de tous les citoyens sans critères de genre, de race, d’appartenances socioculturelles, et des organisations de la société civile. Si nous prenons l’exemple de la radio, qui fut, en son temps, une « nouvelle technologie », celle-ci a permis de porter toutes les paroles grâce à l’émergence des radios libres, souvent associatives, qui réclamaient la liberté d’expression et la défaite du monopole d’État pour démocratiser ce média en Europe. Il en fut d’ailleurs de même pour Internet à ses débuts, qui a redonné « un nouveau souffle » à la théorie des communs. La radio fut un outil de propagande et de résistance certes, de divertissement aussi, mais chacun a pu s’en saisir pour faire passer ses messages, pour l’usage qui convenait à sa communauté. La radio libre, autogérée, permettait alors la participation citoyenne en facilitant la gouvernance par toutes les personnes impliquées dans ce qu’on pourrait voir comme un commun de la connaissance. Ainsi doit être l’intelligence artificielle, saisissable par tout un chacun, extirpée des logiques de profits ou d’experts. Les enjeux sont si grands que chacun devrait contribuer à en définir les usages. Ceux qui le souhaitent doivent avoir la possibilité de comprendre comment sont gouvernés les algorithmes, grâce à la transparence et l’imputabilité des organisations qui les utilisent. Mais également comment et pour quelles fins sont collectionnées de telles données, comment fonctionne par exemple l’apprentissage profond (ou « deep learning ») et à quel dessein est-il déployé. L’IA devrait servir l’intérêt général et le bien commun.

SANDRINE LAMBERT

CANDIDATE AU DOCTORAT EN ANTHROPOLOGIE, UNIVERSITÉ LAVAL

KARINE GENTELET

PROFESSEURE ET TITULAIRE 2020- 2022 DE LA CHAIRE SUR LA JUSTICE SOCIALE ET L’INTELLIGENCE ARTIFICIELLE ABEONA-ENS-OBVIA, UNIVERSITÉ DU QUÉBEC EN OUTAOUAIS (UQO)